قطعا والدین و معلمان در سراسر جهان از بازگشت دانشآموزان به کلاسهای درس، خوشحال هستند! اما دور از چشم آنها، یک تهدید غیرمنتظره موذیانه در صحنه است: هوش مصنوعی ابزارهای جدید و قدرتمند نوشتن خودکار را ایجاد کرده است.

البته، تقلبها همیشه وجود داشتهاند و یک بازی موش و گربه ابدی بین دانش آموزان و معلمان وجود دارد. اما زمانی دانشآموز متقلب مجبور بود به کسی پول بدهد تا برای او مقاله یا تکالیفش بنویسد، یا مقالهای را از وب دانلود کند که به راحتی قابل شناسایی بود و حالا فناوریهای جدید زبان هوش مصنوعی به راحتی نوشتن مقالات با کیفیت بالا را آسان میکنند.

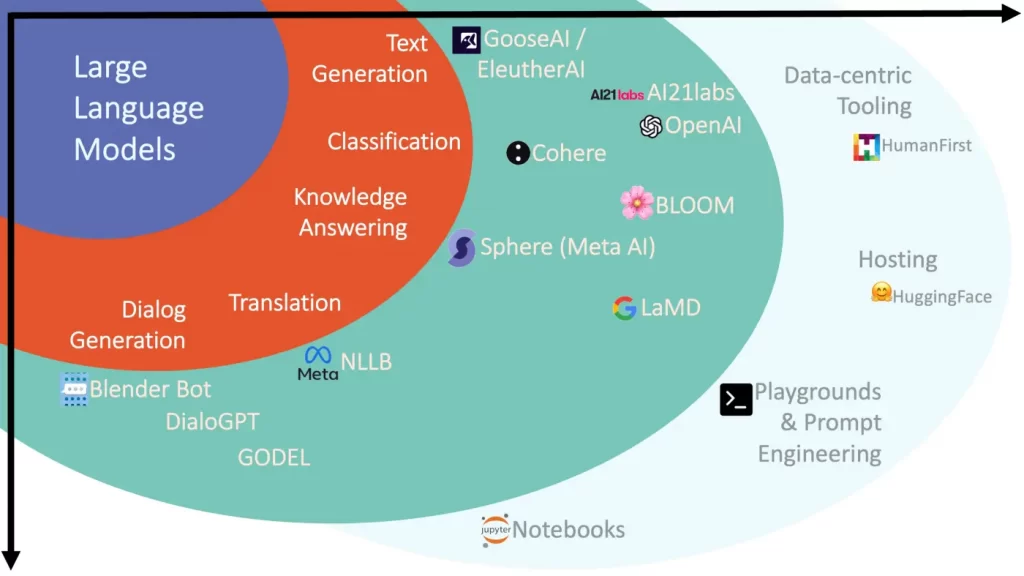

مدل هوش مصنوعی LLM

این فناوری، نوع جدیدی از سیستم یادگیری ماشینی (ML) است که مدل زبان بزرگ (LLM – Large Language Model) نامیده میشود. شما میتوانید به این مدل فرمان بدهید و متن منحصر به فرد را از آن دریافت کنید. این مدلها قادر به تولید انواع خروجیها هستند، اعم از مقاله، پستهای وبلاگ، شعر، نوشتهها، اشعار و حتی کدهای کامپیوتری!

چند سال پیش که این فناوری در ابتدا توسط محققان هوش مصنوعی توسعه داده شد، با احتیاط و نگرانی با آن برخورد شد. OpenAI، اولین شرکتی بود که چنین مدلهایی را توسعه داد اما استفاده خارجی از آنها را محدود کرد و کد منبع جدیدترین مدل خود را منتشر نکرد، زیرا نگران چنین سوء استفادههای احتمالی بود. OpenAI اکنون یک خط مشی جامع در مورد استفادههای مجاز و تعدیل محتوا دارد.

کاربردهای تجاری جلوی احتیاط در هوش مصنوعی را میگیرد

اما با شروع مسابقه تجاریسازی این فناوری، اکنون این اقدامات احتیاطی در سراسر صنعت هوش مصنوعی اتخاذ نمیشود. در شش ماه گذشته، نسخههای تجاری با استفاده آسان از این ابزارهای قدرتمند هوش مصنوعی افزایش یافته که بسیاری از آنها رایگان و بدون محدودیت هستند.

هدف اعلام شده یکی از شرکتها استفاده از فناوری پیشرفته هوش مصنوعی به منظور بیدردسر کردن نوشتن است. یکی دیگر اپلیکیشنی را برای گوشیهای هوشمند منتشر کرد که دقیقا برای دانشآموزان ایجاد شده بود. البته ما در اینجا نام هیچ یک از آن شرکتها را نمیآوریم، زیرا علاقهای به آسانتر کردن کار برای متقلبها نداریم؛ اما یافتن آنها آسان است و حداقل در حال حاضر هیچ هزینهای برای استفاده از آنها نیاز نیست.

اکنون یک دانش آموز دبیرستانی، برای نوشتن یک مقاله انگلیسی و منحصر به فرد در مورد هملت یا نقد و بررسی کوتاه در مورد علل جنگ جهانی اول فقط با چند کلیک فاصله دارد.

با این که مهم است که والدین و معلمان در مورد این ابزارهای جدید تقلب بدانند، اما آنها کار زیادی نمیتوانند در قبال آن انجام دهند. تقریباً غیرممکن است که بچهها را از دسترسی به این فناوریهای جدید منع کنید و زمانی که نوبت به استفاده از آنها میرسد، آنها پیشی میگیرند.

دولتها توانایی قانونگذاری دقیق در هوش مصنوعی را ندارند

همچنین این مشکل در سطحی نیست که خود را به مقررات دولتی برساند. در حال حاضر دولتهای جوامع پیشرفته در حال مداخله اندک برای رسیدگی به سوء استفاده احتمالی از هوش مصنوعی در حوزه های مختلف هستند (به عنوان مثال، در استخدام کارمندان یا تشخیص چهره) و درک بسیار کمتری از مدلهای زبانی و نحوه رسیدگی به آسیبهای احتمالی آنها وجود دارد.

در این شرایط، راهحل این است که شرکتهای فناوری و جامعه توسعهدهندگان هوش مصنوعی مسئولیتپذیری بیشتری اتخاذ کنند. برخلاف حقوق یا پزشکی، هیچ استاندارد پذیرفتهشدهای در فناوری برای رفتار مسئولانه وجود ندارد. الزامات قانونی کمی برای استفاده سودمند از فناوری وجود دارد.

در حوزه پزشکی، استانداردها نتیجه تصمیمات پزشکان پیشرو و صاحبنظر، برای اتخاذ نوعی از خود تنظیمی بودند. در هوش مصنوعی هم نیاز است تا شرکتها یک چارچوب مشترک برای توسعه، استقرار یا انتشار مسئولانه مدلهای هوش مصنوعی ایجاد کنند تا اثرات مضر آنها را بهویژه در دست کاربران مهاجم کاهش دهند.

راهکارهای جلوگیری از سوءاستفاده از هوش مصنوعی

اما شرکتها چه کاری میتوانند انجام دهند که کاربردهای اجتماعی مفید را ترویج کند و از استفادههای بدیهی منفی مانند استفاده از یک تولیدکننده متن برای تقلب در مدرسه جلوگیری کند؟

راهکارهایی وجود دارد. شاید تمام متنهای تولید شده توسط مدلهای زبان تجاری موجود را بتوان در یک مخزن مستقل قرار داد تا امکان تشخیص سرقت ادبی فراهم شود.

مورد دوم محدودیتهای سنی و سیستمهای تأیید سن است تا روشن شود که دانشآموزان نباید به نرمافزار دسترسی داشته باشند.

در نهایت در یک چشمانداز بلندپروازانهتر، توسعهدهندگان پیشرو هوش مصنوعی میتوانند یک هیئت بازبینی مستقل ایجاد کنند که اجازه میدهد چطور و چگونه مدلهای زبان را منتشر کنند و به جای سرعت بخشیدن به تجاریسازی، دسترسی به محققان مستقلی را که میتوانند به ارزیابی خطرات کنند، اولویت دهد.

هوش مصنوعی هم نیاز به تضمین کیفیت دارد

از این گذشته، از آنجایی که مدلهای زبانی را میتوان با بسیاری از برنامههای کاربردی پایین دستی تطبیق داد، هیچ شرکتی نمیتواند تمام خطرات (یا مزایای بالقوه) را پیشبینی کند. سالها پیش، شرکتهای نرمافزاری متوجه شدند که لازم است محصولات خود را برای مشکلات فنی قبل از عرضه به طور کامل آزمایش کنند؛ فرآیندی که اکنون در صنعت به عنوان تضمین کیفیت (QA) شناخته میشود.

زمان آن فرا رسیده است که شرکتهای فناوری نیز متوجه شوند که محصولات آنها باید قبل از عرضه، فرآیند تضمین اجتماعی را طی کنند تا مشکلات را که ممکن است در جامعه به وجود بیاید، پیشبینی کرده و کاهش دهند.

در محیطی که فناوری از دموکراسی پیشی میگیرد، ما باید اخلاق را در مرزهای فناوری درنظر بگیریم. شرکتهای قدرتمند فناوری نمیتوانند پیامدهای اخلاقی و اجتماعی محصولات خود را بهعنوان یک گزینه اختیاری در نظر بگیرند.

اگر آنها صرفاً برای اشغال بازار عجله کنند و سپس در صورت لزوم بعداً عذرخواهی کنند (داستانی که در سالهای اخیر بیش از حد با آن مواجه شدهایم) جامعه تاوان عدم آیندهنگری آنها را می پردازد.

نویسنده این مقاله، راب رایش استاد دانشگاه استنفورد است. او و همکارانش، مهران سهامی و جرمی واینستین، این مقاله را با هم در گاردین نوشتهاند.