تسلا این هفته اطلاعات بیشتری در مورد ابررایانه آینده خود Dojo به اشتراک گذاشت و برخی از سخت افزارهایی را که این سیستم مقیاس بزرگ را تشکیل میدهند، معرفی کرد.

ایلان ماسک، مدیرعامل تسلا، از سال 2019 چندین بار در مورد Dojo، یک «ابررایانه شبکه عصبی» توئیت کرده، اما تاکنون جزئیات کمی را به اشتراک گذاشته است.

در جریان رویداد AI Day این هفته، این شرکت خودروهای الکتریکی و تراشه، تراشه D1 داخلی خود را معرفی کرد که به سیستم و ماژول «training tile» نیرو میبخشد.

گانش ونکاتارامانان، مدیر ارشد سخت افزار اتوپایلوت تسلا و سرپرست پروژه Dojo، گفت که تراشه 7 نانومتری D1 به طور خاص برای یادگیری ماشین و رفع تنگناهای پهنای باند طراحی شده است.

هر یک از 354 گره تراشه D1 دارای یک ترافلاپس (1024 gflops) محاسبه است. ونکاتارامانان گفت که کل تراشه قادر است تا 363 ترافلاپ محاسبه و 10 ترابیت بر ثانیه پهنای باند روی تراشه/4 ترابیت بر ثانیه پهنای باند خارج از تراشه داشته باشد.

وی گفت: «هیچ سیلیکون تاریک، هیچ پشتیبانی قدیمی وجود ندارد، این یک ماشین یادگیری ماشین خالص است. این کاملاً توسط تیم تسلا به صورت داخلی طراحی شده است، از معماری تا پکیج. این تراشه مانند محاسبه سطح GPU با انعطاف پذیری سطح CPU و دو برابر پهنای باند ورودی/خروجی سطح تراشه شبکه است.»

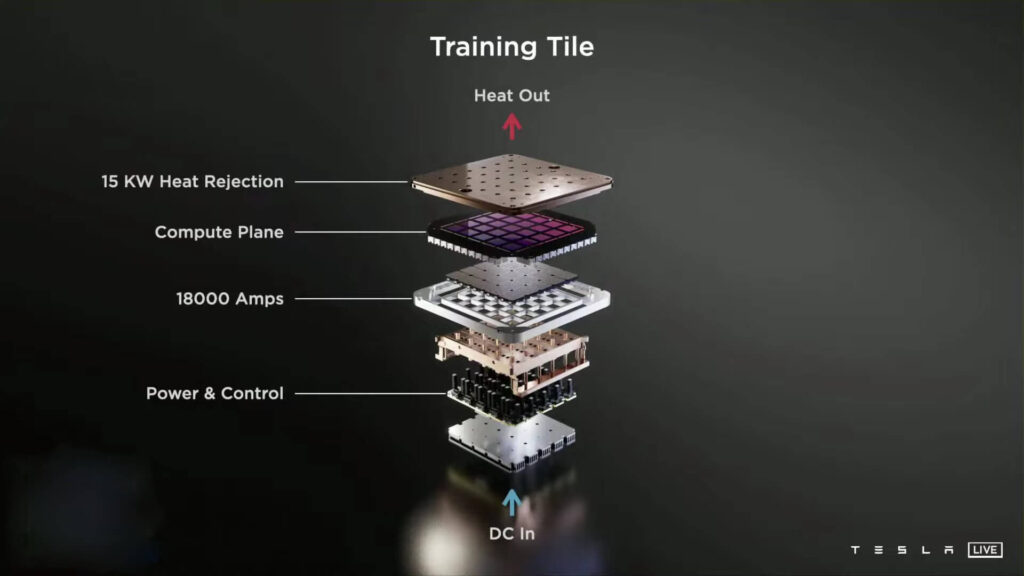

توسعه Training Tiles با استفاده از تراشه D1 Dojo

برای نگهداری تراشهها، این شرکت آنچه را که “Training Tiles” مینامد توسعه داده است تا با آن سیستمهای محاسباتی خود را بسازد. هر کاشی از 25 تراشه D1 در یک ماژول چند تراشه ای یکپارچه تشکیل شده است و هر کاشی 9 پتافلاپ محاسبه کرده و 36 ترابیت بر ثانیه پهنای باند خارج از کاشی را ارائه میدهد.

ونکاتارامانان گفت اولین Training Tile هفته گذشته تحویل و آزمایش شد. برای ایجاد Dojo، این شرکت میگوید که قصد دارد به ازای 100 پتافلاپ محاسبه در هر کابینت، دو سینی شش کاشی را در یک کابینت نصب کند. پس از اتمام کار، این شرکت یک Exapod خواهد داشت که قابلیت1.1 اگزافلاپس از محاسبات هوش مصنوعی به وسیله 10 کابینت متصل شده را دارد. کل سیستم 120 کاشی، 3000 تراشه D1 و بیش از یک میلیون گره را در خود جای میدهد.

ماسک گفت که این سیستم سال آینده عملیاتی میشود.

حتی بدون Dojo، قابلیتهای HPC (محاسبات با کارایی بالا) تسلا قابل توجه است. در ماه ژوئن، آندره کارپاتی، مدیر ارشد هوش مصنوعی در تسلا، در مورد جزئیات یک ابررایانه پیش از Dojo که این شرکت از آن استفاده میکند، صحبت کرد.

این گروه، یکی از سه موردی که شرکت در حال حاضر مشغول به کار است، 720 گره دارد که هر کدام از هشت پردازنده گرافیکی 80 گیگابایتی Nvidia A100 و درمجموع از 5760 A100 در سراسر سیستم استفاده میکنند. بر اساس بنچمارکهای قبلی عملکرد A100 در ابررایانه 63 پتافلاپی Selene خود انویدیا، مجموعه از هشت گره A100 میتواند حدود 81.6 پتافلاپ تولید کند. که دستگاه را در لیست Top500 در رتبه پنجم قرار میدهد.

طی رویداد این هفته، این شرکت گفت که در حال حاضر حدود 10،000 GPU در سه گروه HPC دارد. و همچنین سیستم 5760 که قبلاً ذکر شد که برای آموزش استفاده میشود، دارای یک سیستم 4032 GPU برای آموزش و یک سیستم 1752 GPU برای برچسب زدن خودکار است.

در رویداد هوش مصنوعی این هفته نیز این شرکت از یک ربات 5 اینچی با نام Tesla Bot رونمایی کرد. انتظار میرود نمونه اولیه آن سال آینده عرضه شود.