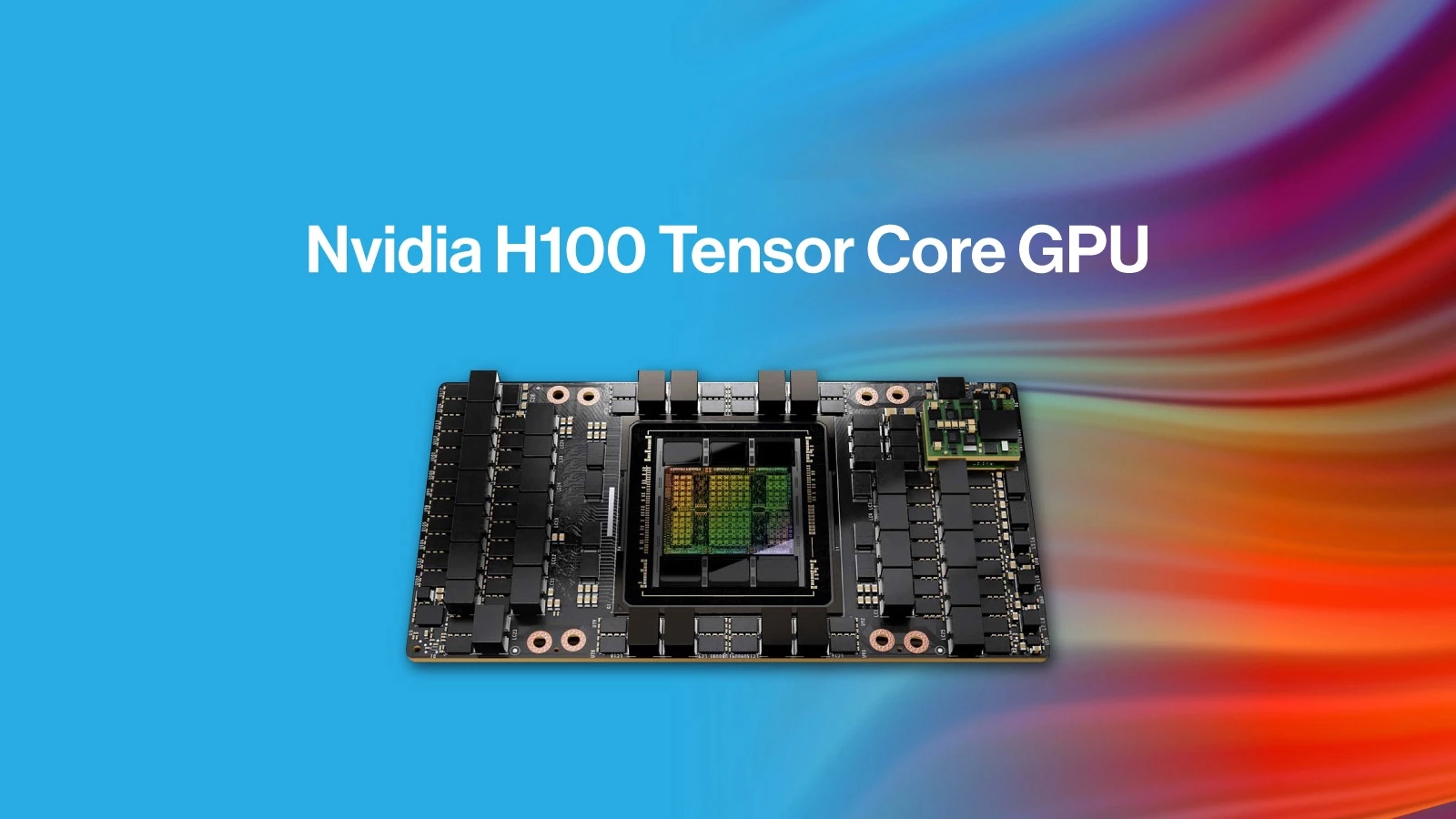

انویدیا دیروز اعلام کرد که پردازندهی گرافیکی Tensor Core H100 Hopper رکوردهای عملکردی جدیدی را در طول اولین کار خود در بنچمارکهای استاندارد صنعتی MLPerf به ثبت رساند و نتایجی را تا 4/5 برابر سریعتر از A100 که در حال حاضر سریعترین تراشه هوش مصنوعی تولیدی انویدیا است، ارائه میدهد.

بنچمارکهای MPerf (که از نظر فنی «MLPerfTM Inference 2.1» نامیده میشود) بارهای کاری «استنتاجی» را اندازهگیری میکند، که نشان میدهد یک تراشه چگونه میتواند یک مدل یادگیری ماشینی آموزشدیده قبلی را روی دادههای جدید اعمال کند. گروهی از شرکتهای صنعتی معروف به MLCommons، بنچمارکهای MLPerf را در سال ۲۰۱۸ برای ارائه یک معیار استاندارد برای انتقال عملکرد یادگیری ماشین به مشتریان بالقوه توسعه دادند.

تراشه H100 به ویژه در معیار BERT-Large که عملکرد پردازش زبان طبیعی (NLP) را با استفاده از مدل BERT توسعهیافته توسط گوگل اندازهگیری میکند، بسیار عالی عمل کرد. انویدیا این نتیجه خاص را مدیون موتور ترانسفورماتور معماری Hopper میداند که به طور خاص مدلهای ترانسفورماتور آموزشی را تسریع میکند. این بدان معناست که H100 میتواند مدلهای زبان طبیعی آینده مشابه GPT-3 OpenAI را تسریع بخشد و آثار نوشتاری را در سبکهای مختلف بنویسد و چتهای محاورهای را انجام دهد.

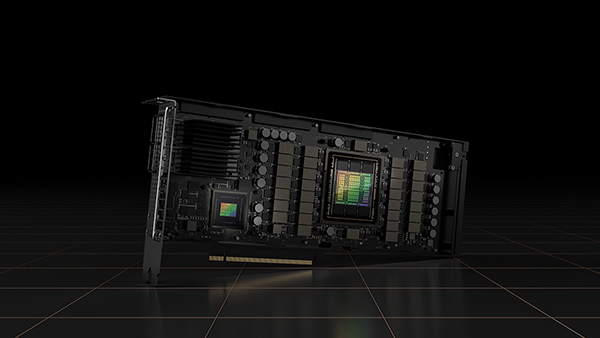

انویدیا H100 را بهعنوان یک تراشه گرافیکی پیشرفته مرکز داده طراحی کرده است که برای برنامههای هوش مصنوعی و ابررایانهای مانند تشخیص تصویر، مدلهای بزرگ زبان، سنتز تصویر و … طراحی شده است. تحلیلگران انتظار دارند که این تراشه جایگزین A100 پرچمدار فعلی GPU مرکز داده شود، اما هنوز در حال توسعه است. از هفته گذشته که محدودیتهای دولت آمریکا بر صادرات تراشهها به چین اعمال شد، این نگرانی ایجاد شد که انویدیا ممکن است نتواند H100 را تا پایان سال 2022 تحویل دهد، زیرا بخشی از توسعه آن در کشور چین انجام میشود.