در سالهای اخیر، دیپفیکهای بیشتری فضای اینترنت را پر کردهاند؛ دیپ فیکها رسانههای ساختگی هستند که برای ساخت آنها تصویر یا ویدیوی شخصی را برداشته و از چهره یا صدای شخص دیگری برای ویدیوی جدید و جعلی استفاده میکنند.

ویژگیهای واقعی دیپفیکها باعث شده است که بسیاری از اطلاعات دروغین، فریبکاری و کلاهبرداری به سرعت در اینترنت پخش شوند. حالا در پاسخ، اینتل فناوری جدیدی به نام «FakeCatcher» را برای شناسایی رسانههای دیپفیک با نرخ دقت ۹۶ درصد معرفی کرد.

دیپفیکها از فناوری برگرفته از یادگیری ماشینی و هوش مصنوعی برای ایجاد برداشتهای دقیق از افراد مشهور و سیاستمداران استفاده میکنند که کارهایی را انجام میدهند و سخنانی میگویند که هرگز انجام نداده و عنوان نکردهاند.

ممکن است ساعتها با فناوریهای موجود طول بکشد تا اعتماد وبگردها به دیپفیک را از بین ببرند، زیرا آنها از یادگیری عمیق برای بررسی نشانههای دستکاری دیجیتال استفاده میکنند.

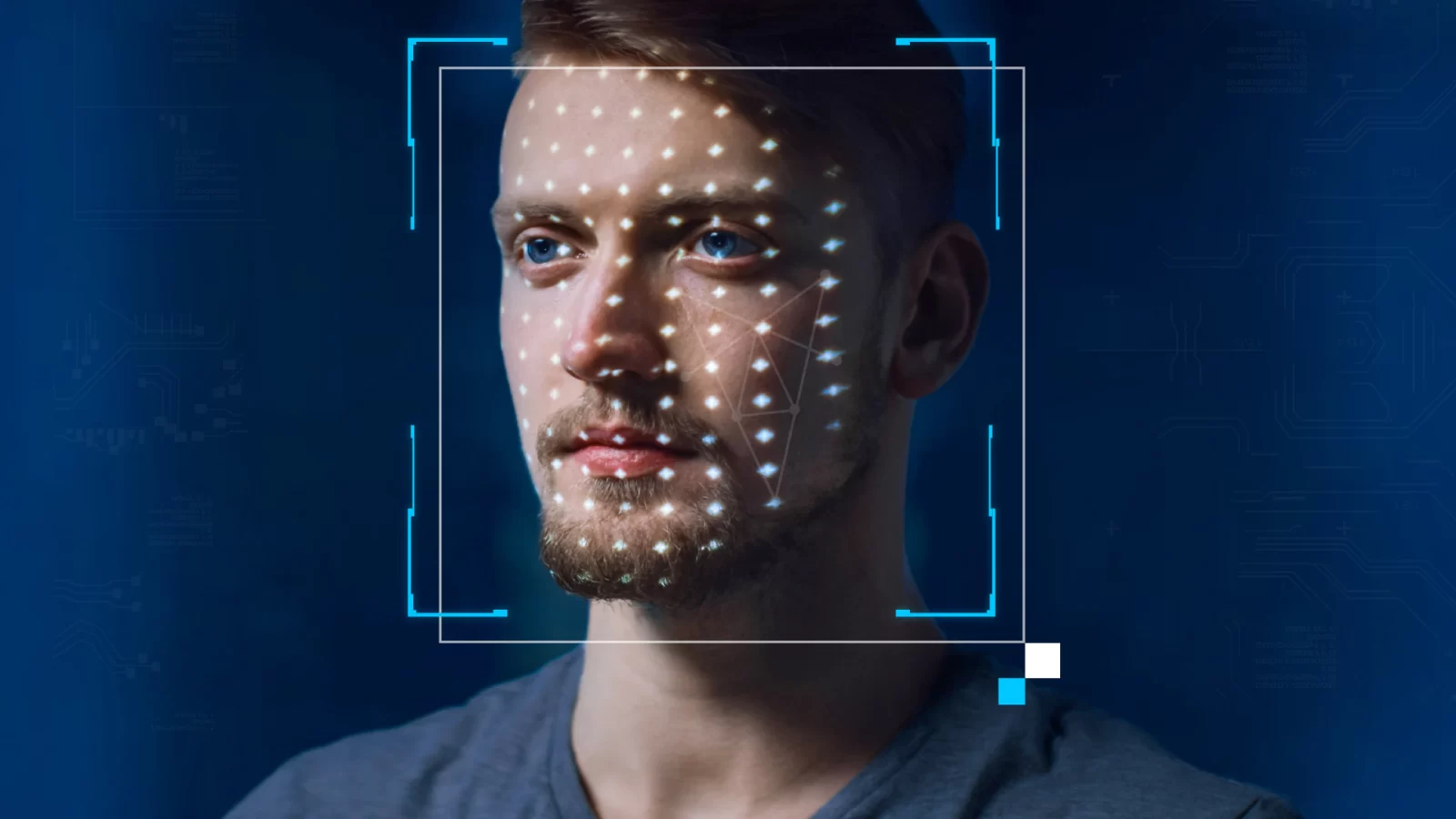

ابزار اینتل برای تشخیص دیپفیک، گردش خون در صورت افراد را بررسی میکند

طبق یک بیانیه مطبوعاتی، FakeCatcher اینتل میتواند با ارزیابی آنچه که انسان واقعی در چهرهاش دارد، یعنی «جریان خون» در پیکسلهای یک ویدیو، یک دیپفیک را در زمان آنی تشخیص دهد.

اینتل میگوید فناوری این شرکت میتواند تغییرات رنگ رگهای ما را هنگام گردش خون در بدن شناسایی کند. سپس سیگنالهای جریان خون از چهره جمعآوری میشوند و توسط الگوریتمهایی ترجمه میشوند تا تشخیص دهند که ویدیو واقعی است یا عمیق.

داشتن نرمافزاری برای کمک به شناسایی دیپ فیکها برای جلوگیری از عواقب مضر آنها، اهمیت فزایندهای پیدا میکند. برخی از ویدئوها و تصاویر عمیق فیک ماهیت گرافیکی دارند و برخی دیگر بی اعتمادی به رسانهها را تداوم میبخشند.

در گذشته، کلاهبرداران از دیپ فیک استفاده میکردند تا به عنوان جویای کار ظاهر شوند و به اطلاعات حساس شرکتها دسترسی پیدا کنند. آنها همچنین برای جعل هویت شخصیتهای برجسته سیاسی برای بیان اظهارات تحریکآمیز استفاده شدهاند. اگرچه برخی از حرکات و رفتارهای موجود در دیپ فیک ماهیت فریبنده خود را از بین میبرد، اما اکثر مردم بدون دقت در فید توییتر خود ویدیوها را مرور میکنند و برای کشف واقعی یا جعلی بودن ویدیو وقت نمیگذارند.