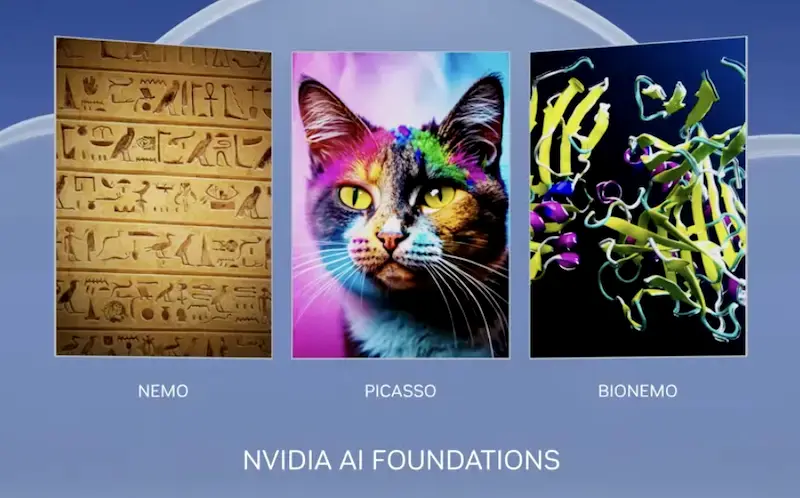

ماه گذشته انویدیا سرویسی به نام AI Foundations را عرضه کرد که به کسبوکارها اجازه میدهد تا مدلهای زبان بزرگ (LLM) را بر اساس دادههای اختصاصی خود آموزش دهند و ایجاد کنند. امروز هم این شرکت ابزاری با نام NeMo Guardrails را معرفی کرد که به توسعهدهندگان کمک میکند از دقیق، مناسب و ایمن بودن برنامههای هوش مصنوعی آنها در AI Foundations اطمینان حاصل کنند.

NeMo Guardrails به مهندسان نرم افزار اجازه میدهد تا محدودیتهایی را در LLM های خود اعمال کنند. به طور خاص، شرکتها میتوانند چارچوبهایی را تنظیم کنند که مانع از پرداختن برنامههایشان به موضوعاتی شود که برای پاسخ به آنها آموزشی ندیدهاند. به عنوان مثال یک چتبات که به عنوان پاسخگوی مشتریان فعالیت میکند، با کمک این نرمافزار، از پاسخ دادن به سؤالی بیربط مانند سوال درباره آبوهوا خودداری میکند. شرکتها همچنین میتوانند محدودیتهای ایمنی و امنیتی را تعیین کنند تا اطمینان حاصل شود که LLMهایشان اطلاعات دقیق را دریافت میکنند و به برنامههایی ایمن متصل میشوند.

به گفته انویدیا، NeMo Guardrails با تمام LLM ها از جمله ChatGPT سازگار است و کار میکند. علاوه بر این، این شرکت ادعا میکند که تقریباً هر توسعهدهنده نرمافزاری میتواند از این نرمافزار استفاده کند. انویدیا در این باره اظهار داشت: «برای استفاده از NeMo Guardrails نیازی نیست که یک متخصص یادگیری ماشین یا دانشمند علوم داده باشید.» از آنجایی که NeMo Guardrails منبع باز است، انویدیا خاطرنشان میکند که با تمام ابزارهایی که توسعهدهندگان سازمانی قبلاً استفاده میکردند، نیز کار میکند.

مشتریان تجاری انویدیا میتوانند از طریق پلتفرم این شرکت تحت عنوان AI Enterprise به NeMo دسترسی پیدا کنند. انویدیا همچنین این چارچوب را از طریق سرویس AI Foundations نیز ارائه میدهد. انتشار NeMo Guardrails پس از آن صورت میگیرد که برخی از برجستهترین هوش مصنوعیهای مولد، از جمله مایکروسافت بینگ و گوگل بارد، به دلیل انتشار اطلاعات نادرست زیر ذرهبین قرار گرفتهاند.